Autor*innen: Lukas Vojkovic und Ann-Christin Thoma

Übersicht

- Intro

- Die KI “Benjamin und ihr Kurzfilm “Sunspring”

- Visuelle Effekte und Unterstützung in der Postproduktion

- Den Erfolg eines Filmes vorhersagen

- Umwandlung alter Filmaufnahmen

- Ersetzt die KI den Menschen?

Intro

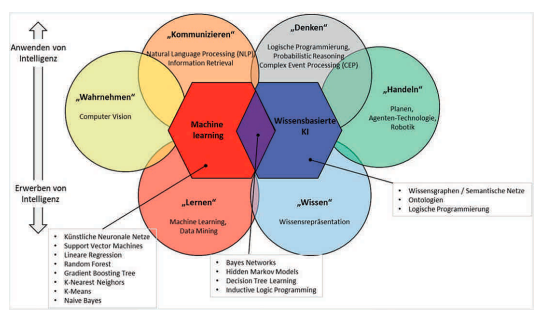

Künstliche Intelligenz (KI) wird normalerweise damit in Verbindung gebracht, Menschen bei Aufgaben zu unterstützen, die durch Automatisierung besser erledigt werden können.

Mit dem fortschreitenden technischen Wandel ist es der KI heutzutage aber nicht nur möglich, fortschriftliche visuelle Effekte in Filmen zu liefern oder den Videoschnitt zu erleichtern, sondern auch Prognosen hinsichtlich des möglichen Erfolgs eines Filmes zu liefern und ganze Storyboards zu verfassen.

Die KI entwickelt sich immer mehr zu einer unausweichlichen Kraft, die Filme zukünftig weiter aufarbeiten und stetig verbessern wird. 1

Die KI „Benjamin“ und ihr Kurzfilm „Sunspring“

Hinsichtlich der Verwendung von KI in der Filmproduktion sticht besonders der Science-Fiction-Kurzfilm „Sunspring“ ins Auge, welcher 2016 debütierte. Das Interessante an diesem Film ist, dass er auf den ersten Blick wie viele andere Science-Fiction-Filme wirken mag – bis zur Erkenntnis, dass dessen Drehbuch ausschließlich von einer KI geschrieben wurde, welche sich selbst den Namen “Benjamin” zuteilte.

Es handelt sich hierbei um ein rekurrentes neuronales Netzwerk namens LSTM

(long short-term memory), welches vorher mit Drehbüchern verschiedenster Science-Fiction-Filme sowie -Serien gespeist wurde. Trotz oder gerade wegen dieses daraus resultierenden, sehr kuriosen Drehbuchs wurde der Kurzfilm mit drei Schauspielenden gedreht und erhielt dadurch große Aufmerksamkeit. 2

Benjamin kreierte im selben Kurzfilm auch die Musik. Das neuronale Netzwerk wurde hier, ähnlich wie bei der vorangegangenen Vorgehensweise, mit vielen verschiedenen Einflüssen trainiert. In diesem Fall mit über 30.000 verschiedensten Popsongs. 3

Visuelle Effekte und Unterstützung in der Postproduktion

Als weitere Art der Unterstützung wird KI inzwischen im Zuge von weiteren bestehenden Produktionsabläufen sogar in Schnittprogramme implementiert. Dort kann sie unter anderem durch nur einen Klick Audio- oder auch Farbanpassungen vornehmen. 4

Doch nicht nur dort kommt künstliche Intelligenz in der Filmwelt der Postproduktion zum Einsatz. Im Bereich der visuellen Effekte kommt sie gerade beim Rotoskopieren zum Tragen, wo bestimmte Teile des Filmmaterials vom Hintergrund separiert werden. Rotoskopieren ist eine Technik, um animierte Filme und komplexe Bewegungsabläufe in Animationsfilmen realistischer wirken zu lassen. Als Beispiel dient hier das Unternehmen Array. Deren neuronales Netzwerk wurde mit Material gefüttert, welches von Visual Effect Artists arrangiert wurde. Nach ausreichendem Training kann das neuronale Netzwerk sogar ohne Unterstützung durch einen Greenscreen arbeiten. 5

Auch die Computersoftware “Massive” sticht im Zuge der visuellen Effekte ins Auge. Ursprünglich für die „Herr der Ringe“-Trilogie entwickelt war diese mit Hilfe von künstlicher Intelligenz in der Lage, computergenerierte Armeen zu erstellen sowie realistische Schlachten in enormen Ausmaßen zu simulieren. “Massiv” erschuf auch andere ikonische Kampfszenen der letzten Jahre, darunter Szenen aus „Game of Thrones“ sowie „Marvel’s Avengers: Endgame“. 6

Den Erfolg eines Filmes vorhersagen

Ein ganz anderer Bereich, welcher durch KI revolutioniert wird, ist die prognostische Ebene. Denn sie ist inzwischen auch dazu in der Lage, Prognosen über den möglichen Erfolg eines Filmes zu treffen. Zum Beispiel soll die vom Datenwissenschaftler Yves Bergquist entwickelte KI „Corto“ dank künstlicher neuronaler Netze in der Lage sein, den Erfolg eines Films vorherzusagen. Das funktioniert nicht nur durch Analyse verschiedenster Elemente aus dem Film direkt, sondern auch über Daten aus sozialen Medien, wo die KI durch verschiedene Äußerungen die Stimmung sowie den kognitiven Zustand der Nutzenden ermittelt, die verschiedene Medieninhalte zugeführt bekommen haben. 7

Umwandlung alter Filmaufnahmen

Aber Künstliche Intelligenz kann auch für ganz andere Zwecke genutzt werden. So konvertierte ein YouTuber namens Denis Shiryaev eine über 100 Jahre alte Filmaufnahme der französischen Lumière-Brüder aus dem Jahr 1895 durch die Unterstützung einer KI auf das Videoformat 4k sowie die Bildrate auf 60 Bilder pro Sekunde. Somit verfrachtete er den Film durch Unterstützung einer KI technisch ins aktuelle Zeitalter. Hier bestand zwar durchaus noch Verbesserungspotential, allerdings geschah der Vorgang mit wenig Aufwand und wies erneut eindrucksvoll auf, zu was künstliche Intelligenz inzwischen in der Lage ist. 8

Ersetzt die KI den Menschen?

Es ist wirklich erstaunlich zu sehen, was für einen großen Einfluss KI in der Welt der Filmproduktion hat und wie viele Bereiche dieser durch sie bereits vereinfacht werden können. Der damit verbundene technische Fortschritt eröffnete die letzten Jahre viele neue innovative Anwendungen in der gesamten Branche und ermöglicht Unternehmen nicht nur, die Effizienz ihrer Arbeitsabläufe zu steigern, sondern auch, ihre Arbeitskosten zu senken und mehr Umsatz zu generieren. 9

Trotz all dieser Vorteile sollte gerade ein Aspekt im Kopf verbleiben:

„KI ist weder nur ein Werkzeug noch ein vollständiger Ersatz für einen Schriftsteller. Man braucht eine Symbiose, um gemeinsam mit der Maschine Kunst zu kreieren.“ 10

Vladimir Alexeev

Quellen

1 Datta, Angana; Goswami, Ruchi (2020): The Film Industry Leaps into Artificial Intelligence: Scope and Challenges by the Filmmakers. Zuletzt aktualisiert am 02.10.2020. Online unter: https://link.springer.com/chapter/10.1007/978-981-15-6014-9_80 [Abruf am 22.11.2022]

2 Alexeev, Vladimir (2022): KI als Filmemacher: Wie man Kurzfilme nur mit Machine-Learning-Modellen macht. Zuletzt aktualisiert am 15.07.2022. Online unter https://1e9.community/t/ki-als-filmemacher-wie-man-kurzfilme-nur-mit-machine-learning-modellen-macht/17523 [Abruf am 27.11.2022]

3 Newitz, Annalee (2016): Movie written by algorithm turns out to be hilarious and intense. Zuletzt aktualisiert am 30.05.2021. Online unter https://arstechnica.com/gaming/2021/05/an-ai-wrote-this-movie-and-its-strangely-moving/ [Abruf am 23.11.2022]

4 Antunes, Jose (2018). Artificial Intelligence at NAB 2018: real world Applications. Zuletzt aktualisiert am 09.04.2018. Online unter https://www.provideocoalition.com/artificial-intelligence-at-nab-2018-real-world-applications/ [Abruf am 27.11.2022]

5 Metz, Cade (2018): Lights, Camera, Artificial Action: Start-Up Is Taking A.I. tot he Movies. The New York Times. Zuletzt aktualisiert am 26.03.2018. Online unter https://www.nytimes.com/2018/03/26/technology/artificial-intelligence-hollywood.html [Abruf am 22.11.2022]

6 Carson, Erin (2022): How ‘Lord of the Rings’ Used AI to Change Big-Screen Battles Forever. Zuletzt aktualisiert am 04.09.2022. Online unter https://www.cnet.com/culture/entertainment/features/how-lord-of-the-rings-used-ai-to-change-big-screen-battles-forever/ [Abruf am 30.11.2022]

7 Schneider, Vanessa (2019): Künstliche Intelligenz & Kultur: Warum Hollywood auf Algorithmen setzt. Zuletzt aktualisiert am 30.09.2019. Online unter https://www.br.de/kuenstliche-intelligenz/so-setzt-hollywood-auf-kuenstliche-intelligenz-machine-learning-100.html [Abruf am 24.11.2022]

8 Westphal, André (2020): Über 120 Jahre alter Film mit KI-Unterstützung zu 4K und 60 fps umgewandelt. Zuletzt aktualisiert am 07.02.2020. Online unter https://stadt-bremerhaven.de/ueber-120-jahre-alter-film-mit-ki-unterstuetzung-zu-4k-und-60-fps-umgewandelt/ [Abruf am 22.11.2022]

9 4 How Artificial Intelligence Is Used in the Film Industry. Online unter https://smartclick.ai/articles/how-artificial-intelligence-is-used-in-the-film-industry/ [Abruf am 28.11.2022]

10 Alexeev, Vladimir (2022): KI als Filmemacher: Wie man Kurzfilme nur mit Machine-Learning-Modellen macht. Zuletzt aktualisiert am 15.07.2022. Online unter https://1e9.community/t/ki-als-filmemacher-wie-man-kurzfilme-nur-mit-machine-learning-modellen-macht/17523 [Abruf am 28.11.2022]