Autorin: Eliza SchnetzerKI

KI

Inhaltsverzeichniss

- KI, was ist das eigentlich?

- Smart-Home-Anwendungen bieten einige Vorteile

- Sicherheitslücken in den Systemen

- Personenbedingte Fehler

- Einfacher Schutz im Alltag

- Fazit: trotz Sicherheitslücken wachsender Trend mit Luft nach oben

- weiterführende Informationen gibt es hier

- Quellen- und Literaturverzeichnis

Wie auch in vielen anderen Bereichen der Technik macht auch das Internet of Things (IoT) große Entwicklungsschritte. Dazu gehören auch sogenannte Smart-Home-Systeme, die eine immer weitere Verbreitung in deutschen Haushalten finden. Aus den vielseitigen Anwendungsbereichen ergeben sich neben komfortablen Alltagshilfen auch einige Fragen zur Sicherheit, gerade hinsichtlich Datenschutzes und Künstliche Intelligenz (KI) . In diesem Artikel sollen einige der Sicherheitslücken aufgedeckt und Lösungsansätze erläutert werden.

KI, was ist das eigentlich?

Immer häufiger hört man heutzutage diesen Begriff, aber was zeichnet die KI eigentlich aus? Normalerweise verarbeitet eine Maschine stumpf Daten. Eine KI ist allerdings in der Lage bestimmte Muster zu erlernen, um Entscheidungen auf der Basis von Informationen zu treffen. Dieses Vorgehen nennt man „Machine Learning“. Damit ist eine menschenähnliche kognitive Leistung möglich. Übertragen wir das auf unsere Smart-Home-Systeme bedeutet, dass, die Geräte erlernen unsere Verhaltensmuster und reagieren entsprechend darauf. Der aktuelle technische Stand ermöglicht das noch nicht umfangreich, zielt aber darauf ab. Bislang entscheiden sind das Erkennen und Befolgen von Wenn-Dann-Regeln.

KI im eigenen Zuhause:

Smart-Home-Anwendungen bieten einige Vorteile

Smart-Home-Anwendungen haben einige Vorteile zu bieten, andernfalls würden sie sich nicht immer wachsender Beliebtheit erfreuen. Dazu gehören unter anderem:

- Erhöhter Komfort: viele Aufgaben müssen nicht mehr selbst erledigt werden, sondern werden bequem von den Smart-Home Anwendungen übernommen. Beispiele hierfür sind z.B. das Saugen von Böden, Rasen mähen oder das automatische Angehen der Kaffeemaschine am Morgen

- Vereinfachte Bedienung: durch die Steuerung per App kann man alle Anwendungen aus einer Stelle heraus bedienen, noch einfacher wird das Ganze mit Spracherkennung/Sprachbefehlen

- mehr Sicherheit: durch das vernetzte System kann der Besitzer durch Push-Nachrichten auf sein Handy informiert werden, wenn z.B. ein Alarm ausgelöst wird. Gleichzeitig kann ein ausgelöster Alarm dazu führen, dass sich Türen und Fenster verriegeln

- Senkung des Energieverbrauch: Geräte sind so programmiert, dass sie möglichst wenig Strom verbrauchen. So kann man z.B. mit Hilfe von einem Timer einstellen, wann das Licht ausgehen soll

Sicherheitslücken in den Systemen

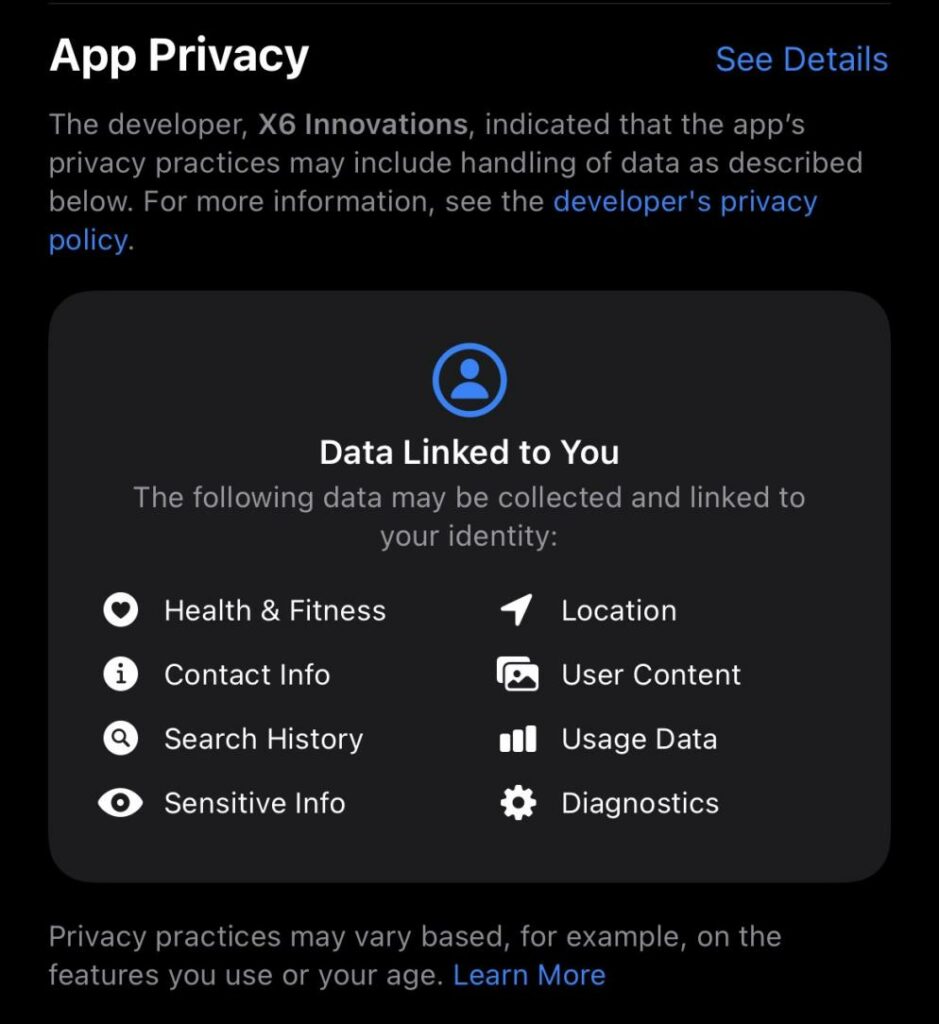

Die komplexe technische Vernetzung bringt auch einige Risiken mit sich, wie sich in den Bereichen des Datenschutzes und der IT-Sicherheit zeigt. Die Smart-Home-Anwendungen sind durchgehend mit dem Internet verbunden. Das macht sie sehr anfällig für den unautorisierten Zugriff durch Hackerangriffe, die sich so den Zugriff zu sämtlichen Geräten in einem Haushalt verschaffen können. Um das zu vermeiden ist das regelmäßige Durchführen von Updates essenziell. Viele Risiken entstehen durch den Anwender selbst. So können fehlende technische Vorkenntnisse und die daraus resultierenden Bedienungsfehler zu schwerwiegenden Sicherheitslücken führen. Daher ist es wichtig, sich mit der Technik der Geräte auseinander zu setzen und ggfs. nochmal die richtige Funktionsweise zu überprüfen. Es stellt sich zudem die Frage, inwiefern die Daten gespeichert und verarbeitet werden. Das ist oft nicht transparent für den Benutzer, und da es sich um sensible personenbezogene Daten wie Kameraaufzeichnungen handelt, ist dieser Punkt nicht zu missachten.

Personenbedingte Fehler

Neben den technischen Fehlerquellen können natürlich auch von Menschenhand erzeugte Fehler Sicherheislücken hervorrufen. Zum einen ist es wichtig, dass sich Anwender vor der Anschaffung intensiv mit der Technik befassen. Oftmals scheitert es an fehlender Planung und das dem Informationsmangel über die Anwendung. Das kann wiederrum zu Anwendungsfehlern führen, die schwerwiegende Sicherheitsmängel bilden können. Wir tendieren oft dazu, zu günstigeren Alternativen zu greifen, was in diesem Fall aber eine fehlende Sicherheitszertifizierung bedeutet und ebenfalls vermehrt Sicherheitslücken aufweißt. Eine noch ausführlichere Hilfe bietet der folgende Artikel: Diese 5 Fehler machen fast alle Smart Home Einsteiger (homeandsmart.de)

Einfacher Schutz im Alltag

Wie kann ich mich also vor den vielfältigen Angriffsmöglichkeiten schützen? Es sind eigentlich ein paar ganz simple Tipps, wie man den Sicherheitsstandard der Smart-Home-Anwendung hochhält:

- keinen direkten Internetzugriff: ist ein System direkt mit dem Internet verbunden, ist es leichter für z.B. Hacker dieses zu finden und zu hacken. Am sichersten ist es, denn Zugriff über ein VPN zu nutzen

- System regelmäßig aktualisieren: für jedes System gibt es reglemäßig Updates, diese sollte man zeitnah durchführen um Bugs und Fehler in der Software zu beheben.

- sichere Passwörter: ein simpler, aber oft missachteter Tipp ist es, ein sicheres Passwort zu vergeben, dass eine Kompination aus Groß- und Kleinschrift, Sonderzeichen und Zahlen beinhaltet. Dieses sollte in regelmäßigen Abständen geändert werden.

- unnötige Dienste ausschalten: schalten Sie nicht benötigte Anwendungen aus, denn was nicht läuft, kann nicht angegriffen werden

Fazit: trotz Sicherheitslücken wachsender Trend mit Luft nach oben

Was lässt sich nun abschließend festhalten? Wenn man einige grundlegende Sicherheitsvorkehrungen beachtet und sich selbst mit den technischen Anwendungen befasst bieten Smart-Home-Anwendungen eine gute Möglichkeit sich den Alltag einfacher zu gestalten. Smart-Home-Anwendungen stehen noch relativ am Anfang ihrer technischen Möglichkeiten und sind auch noch lange kein fester Bestandteil in einem durchschnittlichen Haushalt. Auch die Zukunftserwartungen sind noch nicht erfüllt worden.

«Wir glaubten damals, dass es eine allmächtige, zentrale Intelligenz geben werde, die je nach Stimmung eine automatische Lichtauswahl trifft, ohne unser Zutun Essen für den Kühlschrank nachbestellt und so weiter. Diese Vision ist nicht eingetreten, zumal die Installation und Konfiguration einer einzigen, zentralen Lösung viel zu komplex wäre. Stattdessen gibt es heute viele partielle Lösungen, beispielsweise für die Beleuchtung, die Soundanlagen oder die Sicherheit.»

Zitat von Dr. Andrew Paice, Leiter vom iHomeLab

weiterführende Informationen gibt es hier:

- https://www.verbraucherzentrale.de/wissen/umwelt-haushalt/wohnen/smart-home-das-intelligente-zuhause-6882

- https://www.energie-experten.org/haustechnik/smart-home

- https://www.schoener-wohnen.de/architektur/36906-rtkl-was-ist-eigentlich-ein-smart-home

- Wissenswertes über das Smart Home | Preiswert, nützlich, gut? SWR – YouTube

Quellen- und Literaturverzeichnis

- Baumann, Melanie (2020): Diese 5 Fehler machen fast alle Smart Home Einsteiger. Smart Home Anfängerfehler und wie sie Einsteiger vermeiden. Zuletzt aktualisiert am 02.02.2020. Online unter https://www.homeandsmart.de/fehler-smart-home-einsteiger [Abruf am 24.01.2023]

- Hüwe, Peter ; Hüwe, Stephan (2019): IoT at Home. Smart Gadgets mit Arduino, Rasperry Pi, ESP8266 und Calliope entwickeln. München : Carl Hanser Verlag

- Klein, Ulrich (2020): Smart Home: So vermeiden Sie die 7 größten Fehler bei der Einrichtung. Wir stellen die sieben größten Fehler bei der Einrichtung eines Smart Home vor. Und zeigen, wie Sie diese vermeiden. Zuletzt aktualisiert am 11.02.2020. Online unter https://www.pcwelt.de/article/1182689/smart-home-so-vermeiden-sie-die-7-groessten-fehler-bei-der-einrichtung.html [Abruf am 24.01.2023]

- Leitner, Gerhard (2022): Weise statt smart. Intelligentes Wohnen auf der nächsten Stufe. Wiesbaden : Springer Vieweg

- Maertsch, Judith (2020): Smart Home: Chancen und Risiken. Zuletzt aktualisiert am 22.10.2020. Online unter https://www.vis.bayern.de/digitale_welt/smart_home/smarthome_chancen_risiken.htm [Abruf am 24.01.2023]

- Potor, Marinela (2021): Smart-Home-Geräte: „Die meisten kennen die Risiken nicht.“. Zuletzt aktualisiert am 26.04.2021. Online unter https://www.basicthinking.de/blog/2021/04/26/smart-home-geraete-sicherheitsrisiko/ [Abruf am 24.01.2023]

- Shackelford, Scott J. (2020): The Internet of Things. What everyone needs to know. New York : Oxford University Press

- Vogler, Antonia (2020): Was man über Smart Homes wissen sollte. Zuletz aktualisiert am 09.02.2020. Online unter https://fokus.swiss/business/innovation/wissenswertes-ueber-smart-homes/ [Abruf am 10.12.2022]

Beitragsbild: Bild von Gerd Altmann auf Pixabay